L’intelligence artificielle transforme profondément tous les secteurs d’activité, et avec cette révolution arrive le premier cadre réglementaire mondial dédié spécifiquement à l’IA. L’AI Act européen, adopté en mars 2024, établit des règles claires pour les entreprises développant ou utilisant des systèmes d’IA sur le marché européen. Pour les dirigeants et responsables techniques français, comprendre cette réglementation n’est plus une option mais une nécessité stratégique.

L’essentiel à retenir

L’AI Act européen classe les systèmes d’IA selon 4 niveaux de risque avec des obligations proportionnées. Adopté en 2024, il entre en application progressive jusqu’en 2027, avec des sanctions pouvant atteindre 35 millions d’euros ou 7% du chiffre d’affaires mondial. Les entreprises doivent dès maintenant cartographier leurs systèmes d’IA, évaluer leurs risques et préparer leur documentation technique.

- Comprendre l'AI Act : fondamentaux et objectifs

- Classification des systèmes d'IA selon l'AI Act

- Impacts pratiques de l'AI Act pour les entreprises françaises

- Calendrier de mise en conformité : les étapes clés

- FAQ : questions clés sur l'AI Act européen

- Conclusion : préparer l'avenir de l'IA responsable

- Sources et références

Comprendre l’AI Act : fondamentaux et objectifs

Qu’est-ce que l’AI Act européen exactement ?

L’AI Act est le premier cadre juridique complet au monde spécifiquement conçu pour encadrer le développement, la commercialisation et l’utilisation des systèmes d’intelligence artificielle. Adopté officiellement par le Parlement européen le 13 mars 2024, ce règlement s’applique à toutes les entreprises proposant des solutions d’IA sur le marché européen, qu’elles soient basées dans l’UE ou non. Contrairement à une directive qui nécessite une transposition en droit national, ce règlement s’applique directement dans tous les États membres, garantissant ainsi une harmonisation réglementaire.

La particularité fondamentale de l’AI Act réside dans son approche basée sur les risques, qui catégorise les systèmes d’IA selon quatre niveaux distincts, chacun associé à des exigences spécifiques de conformité. Cette architecture juridique permet d’adapter les contraintes réglementaires à l’impact potentiel de chaque technologie.

Pourquoi cette réglementation a été créée : contexte et enjeux

L’émergence rapide des modèles d’IA générative comme GPT-4, Claude ou Llama 2 a cristallisé les préoccupations concernant les risques liés à l’IA. Le rapport du High-Level Expert Group on AI de la Commission européenne (2020) avait déjà identifié plusieurs risques majeurs : biais algorithmiques, opacité des décisions automatisées, et impacts socio-économiques potentiellement disruptifs.

L’explosion des capacités des grands modèles de langage (LLMs) en 2022-2023 a accéléré le processus législatif européen. La Commission européenne a explicitement adopté une position de leadership, cherchant à définir un « gold standard » mondial pour la régulation de l’IA, comme l’a souligné Thierry Breton, Commissaire européen au Marché intérieur, en septembre 2023.

Cette approche contraste avec celle des États-Unis, qui privilégie une autorégulation sectorielle, et la Chine, qui a adopté des réglementations ciblant spécifiquement les algorithmes de recommandation et l’IA générative sans cadre global équivalent.

Les principes fondamentaux de l’AI Act européen

L’AI Act repose sur trois piliers conceptuels qui structurent l’ensemble du texte :

- L’approche basée sur les risques : Les obligations sont proportionnées au niveau de risque que présente chaque système d’IA, permettant d’éviter une charge réglementaire excessive pour les technologies à faible impact.

- L’équilibre entre protection et innovation : Le règlement vise à protéger les droits fondamentaux tout en préservant la capacité d’innovation des entreprises européennes, notamment à travers des dispositifs comme les « bacs à sable réglementaires » (regulatory sandboxes).

- La gouvernance multi-niveaux : L’application de l’AI Act repose sur un écosystème d’autorités nationales coordonnées par un Comité européen de l’IA, garantissant une interprétation harmonisée du texte.

L’étude d’impact de la Commission européenne (2024) estime que cette approche équilibrée permettrait de réduire les risques liés à l’IA tout en limitant le coût de conformité à 3-4% des investissements totaux en IA pour les entreprises.

Classification des systèmes d’IA selon l’AI Act

Systèmes d’IA interdits : quels sont-ils et pourquoi ?

L’AI Act identifie explicitement certaines applications de l’IA comme présentant un « risque inacceptable » et les interdit purement et simplement sur le territoire européen. Ces interdictions concernent :

- Les systèmes utilisant des techniques subliminales pour manipuler le comportement humain de manière préjudiciable

- Les systèmes exploitant les vulnérabilités de groupes spécifiques liées à l’âge ou au handicap

- Les systèmes de notation sociale (« social scoring ») à usage général par les autorités publiques

- Les systèmes de reconnaissance des émotions en milieu éducatif ou professionnel

- Les systèmes de catégorisation biométrique utilisant des caractéristiques sensibles (orientation sexuelle, opinions politiques, etc.)

- Les systèmes de police prédictive basés sur le profilage individuel

Ces interdictions reflètent les limites éthiques que l’UE considère comme non négociables. Par exemple, l’interdiction des systèmes de « social scoring » est une réponse directe aux préoccupations concernant certains systèmes déployés en Chine, comme l’a souligné le rapport du Centre for Data Ethics and Innovation britannique (octobre 2023).

Systèmes à haut risque : définition et exemples concrets

Les systèmes à « haut risque » constituent la catégorie la plus encadrée parmi les systèmes autorisés. L’annexe III de l’AI Act liste huit domaines spécifiques où les systèmes d’IA sont automatiquement considérés à haut risque :

- Infrastructures critiques (eau, gaz, électricité)

- Éducation et formation professionnelle

- Emploi, gestion des travailleurs et accès au travail indépendant

- Accès aux services privés et publics essentiels

- Application de la loi

- Gestion de la migration et des frontières

- Administration de la justice

- Processus démocratiques (systèmes de vote)

En pratique, cela signifie qu’un système de recrutement automatisé analysant les CV, un algorithme d’évaluation du risque crédit pour l’obtention d’un prêt, ou un système de triage des patients aux urgences seront tous classés comme « à haut risque ».

Selon l’étude EY « AI Regulation Readiness Survey » (2024), 37% des entreprises françaises utilisent déjà au moins un système qui serait classé à haut risque sous l’AI Act, particulièrement dans les secteurs bancaire et assurantiel.

Systèmes à risque limité : obligations de transparence

Les systèmes à « risque limité » ne sont soumis qu’à des exigences de transparence. Cette catégorie comprend :

- Les chatbots et assistants virtuels

- Les systèmes générant ou manipulant du contenu (deepfakes, générateurs d’images)

- Les systèmes de reconnaissance des émotions (hors contextes interdits)

- Les systèmes de catégorisation biométrique (hors caractéristiques sensibles)

Pour ces systèmes, les principales obligations sont d’informer les utilisateurs qu’ils interagissent avec une IA et, dans le cas des deepfakes, de signaler clairement que le contenu a été généré artificiellement.

Cette approche reflète la volonté de maintenir la transparence sans freiner l’innovation. Par exemple, les plateformes comme ChatGPT ou Midjourney devront simplement préciser que leurs outputs sont générés par IA, sans subir les lourdes exigences imposées aux systèmes à haut risque.

Systèmes à risque minimal : cadre allégé

La grande majorité des applications d’IA relèveront de la catégorie « risque minimal », soumise uniquement à des obligations générales très limitées. Cette catégorie inclut notamment :

- Les filtres anti-spam

- Les systèmes de recommandation de contenu (hors contextes à haut risque)

- Les jeux vidéo utilisant l’IA

- La plupart des outils d’aide à la productivité

- Les applications grand public non sensibles

Cette classification permet à l’innovation de se poursuivre avec un minimum de contraintes dans de nombreux domaines d’application. Selon le rapport Gartner « AI Trends and Predictions » (juillet 2023), environ 70% des applications d’IA d’entreprise actuelles tomberaient dans cette catégorie.

| Niveau de risque | Exemples | Principales obligations |

|---|---|---|

| Risque inacceptable (interdit) | Social scoring, manipulation subliminale | Interdiction totale |

| Haut risque | Recrutement IA, diagnostic médical | Évaluation conformité, documentation technique, surveillance humaine |

| Risque limité | Chatbots, générateurs d’images | Transparence, signalement contenu IA |

| Risque minimal | Filtres spam, outils productivité | Obligations générales minimes |

Impacts pratiques de l’AI Act pour les entreprises françaises

Obligations générales pour toutes les entreprises utilisant l’IA

Indépendamment du niveau de risque, l’AI Act établit un socle d’obligations générales qui s’appliquent à tous les systèmes d’IA mis sur le marché européen :

- Respecter le cadre juridique européen en matière de protection des données (RGPD)

- Assurer un niveau minimum de cybersécurité des systèmes

- Se conformer aux normes techniques pertinentes (ISO/IEC)

- Maintenir une documentation de base sur le fonctionnement du système

Pour les entreprises françaises, ces obligations générales s’articulent avec les réglementations sectorielles existantes. Par exemple, les acteurs du secteur financier devront assurer la cohérence de leurs pratiques avec les exigences de l’ACPR concernant l’explicabilité des algorithmes, comme précisé dans le document « Gouvernance des algorithmes d’intelligence artificielle dans le secteur financier » (juin 2020).

Exigences spécifiques selon le niveau de risque

Les obligations pour les systèmes à haut risque sont substantiellement plus contraignantes et comprennent :

- Système de gestion des risques : Mettre en place un processus d’identification, d’analyse et d’atténuation des risques liés à l’utilisation du système.

- Jeux de données d’entraînement : Assurer la qualité, la représentativité et l’absence de biais dans les données utilisées pour développer le système.

- Documentation technique : Maintenir une documentation exhaustive conforme à l’annexe IV, incluant les choix de conception, la méthodologie et les performances.

- Enregistrement automatique (logging) : Conserver les traces des activités du système pour permettre la traçabilité des décisions.

- Transparence : Fournir des informations claires aux utilisateurs sur les capacités et limitations du système.

- Surveillance humaine : Mettre en place des mécanismes permettant une supervision humaine effective.

- Précision, robustesse et cybersécurité : Garantir des performances stables et la résistance aux tentatives de manipulation.

Le cabinet Deloitte estime dans son rapport « AI Act Compliance Cost Analysis » (décembre 2023) que ces exigences représenteront un investissement initial de 250 000 à 500 000 euros pour une entreprise moyenne utilisant un système d’IA à haut risque, suivi de coûts récurrents annuels de 10-15% de l’investissement initial.

Différences d’application selon la taille de l’entreprise

L’AI Act prévoit des dispositions spécifiques pour alléger la charge réglementaire des PME, reconnaissant leurs contraintes en termes de ressources :

- Priorité d’accès aux « bacs à sable réglementaires » permettant de tester des solutions innovantes

- Documentation technique simplifiée pour certaines catégories de systèmes

- Soutien technique des « pôles d’innovation numérique » financés par l’UE

- Réduction des frais administratifs pour les évaluations de conformité

Ces mesures reflètent la volonté de préserver l’écosystème entrepreneurial européen. Selon l’étude France Digitale « Impact de l’AI Act sur l’écosystème startup français » (janvier 2024), 63% des startups françaises spécialisées en IA considèrent que ces allègements sont « significatifs » ou « très significatifs » pour leur capacité à se conformer.

Impacts sectoriels spécifiques

L’impact de l’AI Act varie considérablement selon les secteurs d’activité :

Finance et assurance : Ce secteur sera particulièrement touché, avec de nombreux systèmes classés à haut risque (scoring crédit, détection de fraude, tarification assurantielle). L’articulation avec les réglementations sectorielles comme MiFID II et Solvabilité II crée une complexité supplémentaire.

Santé : Les dispositifs médicaux basés sur l’IA sont déjà régulés par le règlement MDR, mais l’AI Act ajoute des exigences spécifiques, notamment en termes de surveillance humaine et d’explicabilité des décisions.

RH et recrutement : Les systèmes d’évaluation des candidatures et de gestion des talents seront systématiquement classés à haut risque, nécessitant une refonte des pratiques actuelles dans de nombreuses entreprises.

Transport et logistique : Les systèmes de routage, d’optimisation logistique et de maintenance prédictive seront généralement classés à risque minimal, sauf s’ils impactent directement la sécurité (ex: maintenance d’infrastructures critiques).

L’étude sectorielle de McKinsey « The economic potential of AI under the EU AI Act » (octobre 2023) estime que les coûts de conformité varieront de 1% à 7% des investissements totaux en IA selon les secteurs, avec les impacts les plus élevés dans la finance et la santé.

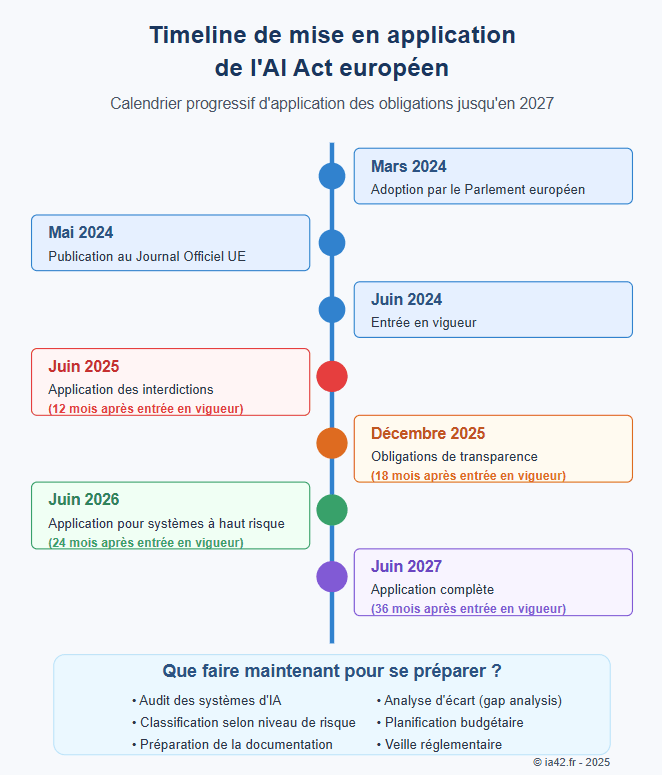

Calendrier de mise en conformité : les étapes clés

Timeline officielle de l’AI Act : dates essentielles

L’application de l’AI Act suit un calendrier progressif qui s’étend jusqu’en 2027 :

- Mars 2024 : Adoption officielle par le Parlement européen

- Mai 2024 : Publication au Journal Officiel de l’UE

- Juin 2024 : Entrée en vigueur (20 jours après publication)

- Juin 2025 : Application des interdictions (12 mois après entrée en vigueur)

- Décembre 2025 : Application des obligations de transparence (18 mois après)

- Juin 2026 : Application pour la majorité des systèmes à haut risque (24 mois)

- Juin 2027 : Application complète pour tous les systèmes (36 mois)

Cette mise en œuvre échelonnée vise à permettre une adaptation progressive des acteurs économiques. Les systèmes d’IA existants bénéficient généralement d’une période de grâce plus longue que les nouveaux systèmes mis sur le marché après l’entrée en vigueur du règlement.

Période transitoire : que faire dès maintenant ?

Malgré ce calendrier étendu, les entreprises doivent engager dès maintenant plusieurs actions préparatoires critiques :

- Audit des systèmes existants : Inventorier tous les systèmes d’IA utilisés dans l’entreprise et les classifier selon les catégories de l’AI Act.

- Analyse d’écart (gap analysis) : Évaluer la distance entre les pratiques actuelles et les exigences futures pour chaque système.

- Planification budgétaire : Anticiper les coûts de mise en conformité et les intégrer aux cycles budgétaires.

- Sensibilisation interne : Former les équipes techniques et managériales aux implications de l’AI Act.

- Veille réglementaire : Suivre les actes d’exécution et les lignes directrices qui préciseront certains aspects du règlement.

Le cabinet PwC recommande dans son « AI Act Preparation Guide » (février 2024) de prioriser ces actions selon le niveau de risque des systèmes et leur importance stratégique pour l’entreprise.

FAQ : questions clés sur l’AI Act européen

L’AI Act s’applique à toutes les entreprises qui mettent sur le marché européen ou mettent en service des systèmes d’IA, indépendamment de leur lieu d’établissement. Cela inclut les fournisseurs (développeurs), les importateurs, les distributeurs et les utilisateurs professionnels de systèmes d’IA. Une entreprise française utilisant un logiciel d’IA américain sera concernée, tout comme un développeur français exportant ses solutions vers d’autres pays européens.

Un système d’IA est considéré à haut risque dans deux cas : soit il est destiné à être utilisé comme composant de sécurité d’un produit soumis à une législation d’harmonisation de l’UE (ex: dispositifs médicaux, jouets), soit il appartient à l’un des huit domaines listés à l’annexe III du règlement. En cas de doute, l’approche prudente consiste à consulter un expert juridique spécialisé ou à contacter directement l’autorité nationale de surveillance du marché (en France, probablement la CNIL ou une nouvelle autorité dédiée).

Les délais varient selon la nature des obligations. Les interdictions totales s’appliqueront dès juin 2025, les obligations de transparence pour les systèmes à risque limité à partir de décembre 2025, et les exigences pour les systèmes à haut risque majoritairement en juin 2026. Certaines dispositions complexes bénéficient d’un délai supplémentaire jusqu’en juin 2027. Toutefois, pour les nouveaux systèmes mis sur le marché après juin 2024, les délais peuvent être plus courts.

Oui, avec les modèles quantifiés actuels (4-8 bits), des assistants performants peuvent fonctionner entièrement hors ligne sur hardware standard. Les modèles comme Llama 3 8B ou Mistral 7B offrent des performances satisfaisantes pour de nombreux cas d’usage tout en tenant sur un seul GPU consumer. Pour les appareils mobiles, des modèles ultra-légers (1-3B paramètres) commencent à offrir des fonctionnalités limitées mais utiles en contexte déconnecté.Les sanctions administratives prévues par l’AI Act sont substantielles et proportionnées à la gravité de l’infraction. Elles peuvent atteindre :

– 35 millions d’euros ou 7% du chiffre d’affaires mondial pour les infractions les plus graves (utilisation de systèmes interdits)

– 15 millions d’euros ou 3% du chiffre d’affaires mondial pour la fourniture d’informations incorrectes

– 7,5 millions d’euros ou 1,5% du chiffre d’affaires mondial pour les autres violations

Ces montants maximaux font de l’AI Act l’une des réglementations les plus strictes au monde en matière de sanctions, dépassant même celles du RGPD (20 millions d’euros ou 4% du chiffre d’affaires).Oui, avec les modèles quantifiés actuels (4-8 bits), des assistants performants peuvent fonctionner entièrement hors ligne sur hardware standard. Les modèles comme Llama 3 8B ou Mistral 7B offrent des performances satisfaisantes pour de nombreux cas d’usage tout en tenant sur un seul GPU consumer. Pour les appareils mobiles, des modèles ultra-légers (1-3B paramètres) commencent à offrir des fonctionnalités limitées mais utiles en contexte déconnecté.

La documentation technique requise par l’AI Act est détaillée dans l’annexe IV du règlement. Elle doit inclure :

– La description générale du système et de son utilisation prévue

– Les spécifications détaillées de conception

– Les informations sur le développement, notamment les méthodologies et techniques

– Les données d’entraînement, validation et test utilisées

– Les mesures de surveillance humaine implémentées

– Les résultats de l’évaluation des risques

– Les mesures de gestion des risques identifiés

– Les procédures de test et validation

Cette documentation doit être maintenue à jour pendant toute la durée de vie du système. Pour faciliter ce processus, plusieurs templates sont en cours de développement par des organisations comme l’AFNOR et les associations professionnelles du secteur numérique.

Conclusion : préparer l’avenir de l’IA responsable

Les tendances futures de la réglementation IA

L’AI Act constitue un premier pas majeur, mais l’environnement réglementaire continuera d’évoluer. Plusieurs tendances se dessinent déjà :

- Harmonisation internationale progressive : Les principes de l’OCDE sur l’IA (2019) et les travaux du Global Partnership on AI suggèrent une convergence progressive des approches réglementaires, même si des différences significatives persisteront.

- Régulations sectorielles complémentaires : Des cadres spécifiques émergeront probablement pour des secteurs comme la défense, la santé ou la finance, avec des exigences adaptées aux enjeux particuliers de ces domaines.

- Évolution continue des classifications : Avec l’évolution rapide des technologies, les définitions des niveaux de risque et la classification des systèmes seront régulièrement réévaluées par le Comité européen de l’IA.

Vers une IA de confiance : au-delà de la conformité

La conformité réglementaire ne doit pas être perçue uniquement comme une contrainte, mais comme une opportunité de développer une approche plus responsable et durable de l’IA :

- Avantage concurrentiel : Les entreprises qui intègrent précocement les principes d’IA éthique dans leur approche bénéficieront d’un avantage réputationnel significatif, particulièrement valorisé par les consommateurs européens.

- Confiance des utilisateurs : La transparence et la supervision humaine renforcent la confiance des utilisateurs, favorisant l’adoption de nouvelles solutions.

- Prévention des risques : Une approche proactive de la conformité permet d’éviter des coûts substantiels liés aux sanctions, rappels de produits, ou dommages réputationnels.

L’étude BCG « The Business Case for AI Ethics » (septembre 2023) indique que 72% des entreprises ayant adopté des pratiques d’IA responsable ont observé un impact positif sur leur réputation et 54% rapportent une amélioration de la satisfaction client.

En définitive, l’AI Act représente un changement de paradigme pour le secteur de l’IA en Europe, établissant un équilibre entre innovation et protection des droits fondamentaux. Les entreprises françaises qui adopteront une approche stratégique de mise en conformité ne se contenteront pas de respecter la loi – elles se positionneront avantageusement dans un marché où la confiance devient un différenciateur clé.

A retenir

– L’AI Act introduit une approche basée sur les risques avec 4 niveaux d’obligation

– Les entreprises françaises doivent dès maintenant cartographier leurs systèmes et évaluer leur niveau de risque

– Les systèmes à haut risque nécessitent une documentation exhaustive et des contrôles renforcés

– La mise en conformité représente un investissement significatif mais aussi une opportunité stratégique

Sources et références

- Commission européenne, « Regulation on Artificial Intelligence » (AI Act), mars 2024

- High-Level Expert Group on AI, « Ethics Guidelines for Trustworthy AI », avril 2020

- McKinsey & Company, « The economic potential of AI under the EU AI Act », octobre 2023

- EY, « AI Regulation Readiness Survey », janvier 2024

- France Digitale, « Impact de l’AI Act sur l’écosystème startup français », janvier 2024

- CNIL, « IA et données personnelles : préparer l’entrée en vigueur de l’AI Act », février 2024

- Deloitte, « AI Act Compliance Cost Analysis », décembre 2023

- PwC, « AI Act Preparation Guide », février 2024

- Gartner, « AI Trends and Predictions », juillet 2023

- ACPR, « Gouvernance des algorithmes d’intelligence artificielle dans le secteur financier », juin 2020

- BCG, « The Business Case for AI Ethics », septembre 2023

- Centre for Data Ethics and Innovation, « Global approaches to AI regulation », octobre 2023