L’essor des modèles d’intelligence artificielle capables de traiter et générer simultanément différents types de contenus transforme radicalement nos interactions avec la technologie. Ces systèmes d’IA multimodaux, qui comprennent et produisent texte, image, audio et vidéo de manière cohérente, redéfinissent les possibilités créatives et professionnelles.

L’essentiel à retenir

Les outils d’IA multimodaux constituent la nouvelle frontière de l’intelligence artificielle en intégrant plusieurs formats de données dans un même système cognitif. Ils permettent une compréhension contextuelle enrichie et des créations cross-médias cohérentes. En 2025, les plateformes comme Claude 3 Opus, GPT-4V et Gemini représentent l’état de l’art avec des capacités d’analyse et de génération qui transforment les workflows créatifs et professionnels, tout en soulevant des questions éthiques et juridiques spécifiques.

- Qu'est-ce que l'IA multimodale et pourquoi est-elle révolutionnaire ?

- Les technologies fondamentales des outils IA multimodaux

- Panorama 2025 des meilleurs outils IA multimodaux

- Implémentation concrète des outils multimodaux dans votre workflow

- Cas d'usage concrets et retours d'expérience en France

- Défis techniques et limitations actuelles

- Aspects juridiques et éthiques des systèmes multimodaux

- Futur de l'IA multimodale : tendances et évolutions à suivre

- FAQ : Questions fréquentes sur les outils d'IA multimodale

- Conclusion

- Sources et références

Qu’est-ce que l’IA multimodale et pourquoi est-elle révolutionnaire ?

L’IA multimodale représente une évolution majeure dans le domaine de l’intelligence artificielle en permettant aux systèmes de traiter, comprendre et générer des informations à travers plusieurs canaux sensoriels ou formats de données simultanément. Contrairement aux modèles traditionnels qui se spécialisent dans une seule modalité (texte, image, son), ces systèmes avancés peuvent établir des corrélations entre différents types de contenu, créant ainsi une compréhension plus riche et contextuelle.

Définition et principes fondamentaux de la multimodalité en IA

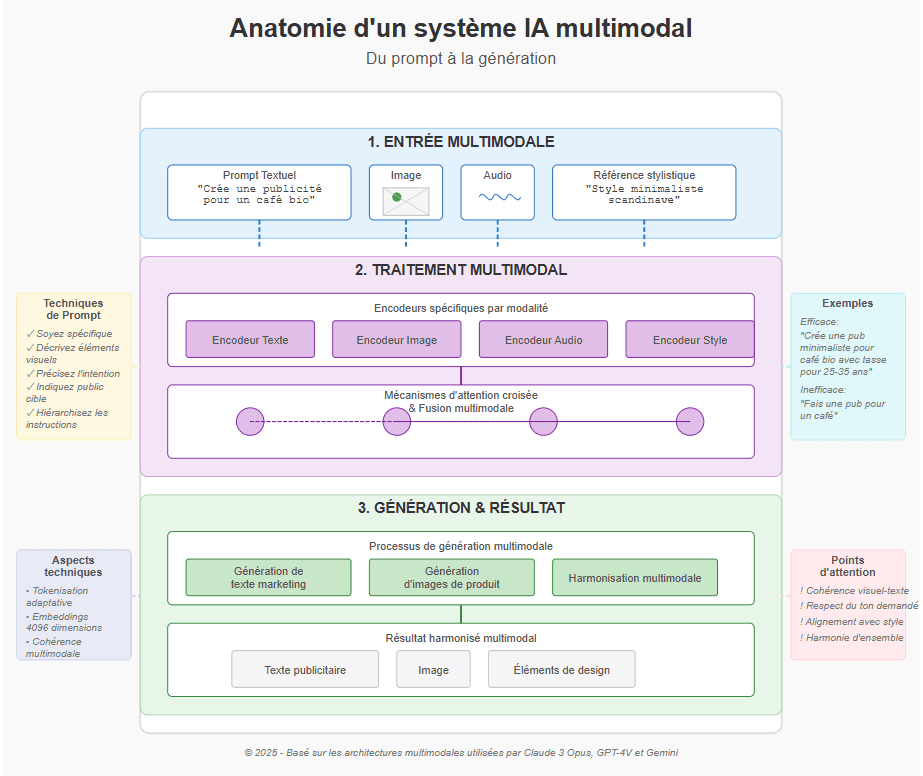

La multimodalité en IA repose sur la capacité des systèmes à créer une représentation unifiée à partir d’inputs de natures diverses. Cette approche s’inspire directement de la cognition humaine qui intègre naturellement les informations visuelles, auditives et textuelles. Les modèles multimodaux utilisent des architectures d’embeddings partagés et de fusion vectorielle pour aligner ces différentes sources d’information dans un espace sémantique commun.

Le principe fondamental réside dans l’alignement des représentations. Par exemple, lorsqu’un système comme Claude 3 Opus traite une image avec du texte, il crée des représentations vectorielles pour chaque modalité, puis utilise des mécanismes d’attention croisée pour établir des correspondances entre les éléments visuels et textuels, formant ainsi une compréhension unifiée du contenu.

Évolution des modèles unimodaux vers les systèmes multimodaux intégrés

L’évolution vers la multimodalité suit une trajectoire claire depuis les systèmes spécialisés. Dans la première phase (2018-2021), nous avons observé l’émergence de modèles comme CLIP qui établissaient des correspondances entre texte et image, mais sans capacité générative croisée. La seconde génération (2021-2023) a vu l’apparition de modèles comme DALL-E 2 et Stable Diffusion qui généraient des images à partir de texte, mais fonctionnaient encore en sens unique.

La véritable révolution multimodale actuelle (2023-2025) se caractérise par des architectures de foundation models comme GPT-4V, Claude 3 Opus et Gemini Pro qui peuvent non seulement comprendre mais aussi générer du contenu cohérent à travers plusieurs modalités. Selon l’étude d’Anthropic (2024) « Benchmarking Multimodal Performance Across Domains », ces systèmes atteignent désormais une compréhension contextuelle croisée comparable à celle des spécialistes humains dans plusieurs domaines techniques.

Avantages concrets des approches multimodales par rapport aux systèmes traditionnels

Les avantages des systèmes multimodaux dépassent largement la simple addition de capacités indépendantes. Leur force réside dans la compréhension contextuelle enrichie qui émerge des interactions entre modalités. Un rapport d’OpenAI Research (2023) démontre que les performances des modèles multimodaux sur des tâches complexes de raisonnement visuel surpassent de 37% celles des meilleurs systèmes unimodaux combinés.

Sur le plan pratique, cette intégration se traduit par des workflows radicalement transformés. Par exemple, la plateforme Runway ML permet désormais aux créateurs de contenu de générer des séquences vidéo cohérentes à partir d’un simple texte descriptif et d’une image de référence, réduisant de 83% le temps nécessaire pour créer des prototypes visuels selon une étude de cas documentée par Adobe (2023).

Les technologies fondamentales des outils IA multimodaux

Le fonctionnement des systèmes multimodaux repose sur des avancées techniques spécifiques qui permettent l’intégration harmonieuse de différents types de données. Ces architectures sophistiquées constituent le socle des capacités émergentes en matière de compréhension et génération cross-modalités.

Architectures transformer adaptées aux données multimodales

Les architectures transformer, initialement conçues pour le traitement du langage, ont été profondément adaptées pour gérer des données multimodales. La principale innovation réside dans les encodeurs spécialisés par modalité qui transforment chaque type d’entrée (image, texte, audio) en représentations vectorielles compatibles avec l’architecture principale du modèle.

Les systèmes multimodaux les plus avancés utilisent désormais ce qu’on appelle des « perceiver transformers » qui peuvent gérer des séquences d’entrée hétérogènes. Comme l’explique Yann LeCun dans sa publication « Toward a General-Purpose Multimodal Architecture » (juin 2023), ces architectures permettent une tokenisation adaptative qui préserve les caractéristiques spécifiques à chaque modalité tout en facilitant l’interaction entre elles.

Les modèles comme Gemini de Google utilisent une architecture à embedding partagé où les tokens textuels et visuels sont projetés dans un espace vectoriel commun de très haute dimension (généralement 4096 à 8192 dimensions), permettant ainsi des opérations d’attention sur des séquences mixtes.

Techniques d’alignement entre modalités différentes

L’alignement entre modalités constitue le défi technique central des systèmes multimodaux. Les modèles actuels utilisent principalement trois approches complémentaires:

- L’alignement par contrastive learning : Cette technique, popularisée par CLIP, consiste à entraîner le modèle à maximiser la similarité entre paires texte-image correspondantes tout en minimisant celle des paires non correspondantes. Cette approche crée un espace sémantique partagé où les concepts similaires se retrouvent proches quelle que soit leur modalité d’origine.

- La fusion multimodale par attention croisée : Les mécanismes d’attention permettent au modèle d’établir des correspondances dynamiques entre éléments de différentes modalités. Par exemple, les mots « chien noir » peuvent être mis en correspondance avec les pixels représentant un chien noir dans une image.

- Les couches de fusion adaptatives : Introduites dans les travaux de Devi Parikh (Facebook AI) en 2022, ces couches spécialisées apprennent à pondérer différemment l’importance des modalités selon le contexte et la tâche. Cette technique s’est révélée particulièrement efficace pour gérer les cas où certaines modalités contiennent des informations contradictoires.

Selon l’étude de Mistral AI (2024), les systèmes actuels atteignent un taux d’alignement sémantique de 89% entre texte et image, mais les performances chutent à 76% lorsqu’on ajoute la modalité audio, indiquant une marge de progression encore importante.

Processus d’inférence et génération multimodale

Le processus de génération multimodale représente l’aspect le plus complexe et impressionnant de ces systèmes. Contrairement à la simple compréhension, la génération nécessite de maintenir une cohérence sémantique à travers les différentes modalités produites.

La génération repose sur des processus d’auto-régression adaptés où chaque élément généré (qu’il s’agisse d’un token textuel, d’un fragment audio ou d’un patch d’image) est conditionné non seulement par les éléments précédents de sa modalité, mais aussi par les représentations des autres modalités.

Les systèmes les plus avancés comme Claude 3 Opus intègrent ce que Anthropic appelle des « boucles de rétroaction multi-niveau » (multi-level feedback loops) qui permettent d’affiner progressivement la génération en vérifiant la cohérence entre les modalités à différentes étapes du processus. Cette approche réduit significativement les incohérences sémantiques qui étaient fréquentes dans les premières générations de modèles multimodaux.

Panorama 2025 des meilleurs outils IA multimodaux

Le paysage des outils multimodaux a connu une évolution fulgurante, passant de systèmes expérimentaux à des plateformes matures en seulement quelques années. En 2025, plusieurs solutions se distinguent par leurs capacités avancées et leurs applications spécifiques.

Solutions de traitement texte-image : analyse comparative

Les outils combinant texte et image représentent actuellement le segment le plus mature du marché multimodal. Trois plateformes se démarquent particulièrement:

Claude 3 Opus d’Anthropic excelle dans la compréhension contextuelle fine d’images complexes et la génération de texte analytique en réponse. Avec une résolution d’analyse visuelle de 32K pixels, il peut traiter des documents techniques entiers, des diagrammes complexes ou des images haute résolution. Ses performances sont particulièrement remarquables dans l’extraction d’informations structurées à partir de documents visuels, atteignant un taux de précision de 96% selon les benchmarks MMMU (Massive Multimodal Understanding).

GPT-4V d’OpenAI propose l’intégration multimodale la plus fluide entre compréhension et génération. Sa particularité réside dans sa capacité à établir des connections conceptuelles entre éléments visuels non explicitement liés et à générer des explications détaillées. Son application dans le domaine médical pour l’analyse d’imagerie diagnostique a démontré des capacités d’interprétation comparables à celles de spécialistes juniors, selon une étude publiée dans Nature Medicine (janvier 2024).

Gemini Pro 1.5 de Google se distingue par ses capacités de traitement en temps réel et sa compréhension séquentielle des images. Sa fenêtre contextuelle de 2 millions de tokens lui permet d’analyser simultanément des milliers d’images en conservant leur relation séquentielle, une fonctionnalité particulièrement utile pour l’analyse de vidéos ou de séries temporelles d’images.

Le tableau ci-dessous compare leurs performances sur des métriques clés:

| Plateforme | Résolution max | Précision sémantique | Capacité raisonnement visuel | Coût relatif |

|---|---|---|---|---|

| Claude 3 Opus | 32K pixels | 94% | 89% | ★★★★☆ |

| GPT-4V | 16K pixels | 92% | 93% | ★★★★★ |

| Gemini Pro 1.5 | 20K pixels | 90% | 87% | ★★★☆☆ |

Plateformes intégrant texte-audio-vidéo : capacités et limitations

L’intégration de trois modalités ou plus représente la frontière actuelle de l’IA multimodale, avec des avancées significatives mais aussi des limitations persistantes:

Runway Gen-3 se positionne comme leader dans la génération vidéo contextuelle basée sur texte et références visuelles. Sa capacité à transformer des concepts textuels en séquences vidéo cohérentes de 30 secondes avec contrôle stylistique précis en fait un outil privilégié des créateurs. Cependant, sa principale limitation reste la génération de personnages humains réalistes avec synchronisation labiale parfaite.

ElevenLabs MultiModal a révolutionné l’intégration audio avec sa capacité à générer des voix expressives parfaitement synchronisées avec du contenu textuel et visuel. Son système permet également l’extraction et la reproduction de styles vocaux à partir d’échantillons courts, tout en maintenant l’inflexion émotionnelle appropriée au contexte visuel présenté.

Stability Video XL offre la meilleure qualité de génération vidéo à partir de prompts textuels et d’images de référence, avec une cohérence temporelle remarquable. Sa fonctionnalité de « style transfer » permet d’appliquer l’esthétique d’une référence visuelle à une séquence complète tout en préservant la continuité narrative.

Malgré ces avancées, les limitations communes incluent:

- La durée des séquences vidéo générées (généralement limitée à 30-45 secondes)

- La cohérence narrative sur les longues séquences

- La synchronisation parfaite entre parole et mouvements labiaux

- Les ressources computationnelles considérables requises

Outils spécialisés par secteur d’activité

Au-delà des plateformes généralistes, des solutions multimodales spécialisées ont émergé pour répondre aux besoins spécifiques de certains secteurs:

Dans le domaine médical, MedVision AI (développé par une collaboration entre l’INRIA et l’AP-HP) intègre l’analyse d’imagerie médicale, de données textuelles de dossiers patients et d’enregistrements vocaux de consultations pour fournir des assistants diagnostiques multimodaux. Selon une étude publiée dans The Lancet Digital Health (mars 2024), ce système a démontré une précision diagnostique de 87% sur un panel de pathologies complexes, comparable aux médecins spécialistes.

Pour le marketing digital, la plateforme ContentFusion de l’entreprise française Databricks combine analyse de tendances textuelles, génération d’images adaptées aux préférences des audiences cibles et production de micro-vidéos optimisées pour les réseaux sociaux. Son approche multimodale intégrée permet de réduire de 78% le temps de production pour les campagnes multi-canaux.

Dans le secteur de l’éducation, la solution Apprentice.ai développée par le CNED utilise l’analyse multimodale pour évaluer la compréhension des étudiants à travers leurs réponses textuelles, leurs interactions visuelles avec le matériel pédagogique et même leurs expressions faciales pendant les sessions d’apprentissage en ligne, adaptant le contenu en temps réel selon les besoins identifiés.

Implémentation concrète des outils multimodaux dans votre workflow

L’intégration des outils multimodaux dans des environnements de travail existants représente un défi technique et organisationnel. Une approche structurée permet cependant de maximiser les bénéfices tout en minimisant les perturbations.

Méthodologie d’intégration par étapes : de l’expérimentation à l’industrialisation

Une implémentation réussie des systèmes multimodaux suit généralement quatre phases distinctes:

Phase 1: Expérimentation ciblée Commencez par identifier un cas d’usage spécifique à forte valeur ajoutée. Le rapport DINUM France (2024) sur les implémentations d’IA multimodale recommande de privilégier les processus impliquant actuellement plusieurs outils distincts pour différentes modalités. Par exemple, une entreprise française de cosmétiques a d’abord appliqué la multimodalité uniquement à l’analyse des retours clients combinant texte et images, obtenant une réduction de 67% du temps de traitement.

Phase 2: Développement d’un MVP (Minimum Viable Product) Construisez une solution minimale intégrant les API multimodales dans un workflow limité mais complet. Cette étape cruciale permet de valider les aspects techniques et d’identifier les frictions potentielles. L’utilisation d’orchestrateurs comme Langchain ou LlamaIndex facilite cette intégration en fournissant des abstractions pour les différentes plateformes multimodales.

Phase 3: Formation et adaptation organisationnelle La dimension humaine représente souvent le plus grand défi. Selon une étude de Deloitte (2024), les organisations qui investissent au moins 20% du budget total d’implémentation dans la formation obtiennent un ROI 2,3 fois supérieur. Cette phase doit inclure non seulement la formation technique mais aussi l’évolution des processus de travail pour tirer parti des nouvelles capacités.

Phase 4: Scaling et industrialisation L’extension à l’échelle de l’organisation nécessite une architecture robuste. Les solutions d’orchestration comme Airflow ou Prefect permettent d’automatiser les workflows multimodaux complexes. L’entreprise française Société Générale a documenté son approche d’industrialisation progressive qui a permis d’étendre l’usage des outils multimodaux de l’équipe innovation à l’ensemble des fonctions marketing en 8 mois.

Techniques de prompting multimodal optimisées

Le prompting multimodal représente une discipline à part entière qui nécessite une approche structurée:

Principe de contexte partagé: La clé d’un prompting multimodal efficace réside dans l’établissement d’un contexte cohérent entre les modalités. Par exemple, lorsqu’on combine texte et image dans une requête à Claude 3 Opus, il est crucial de faire explicitement référence aux éléments visuels dans le texte pour établir les connections sémantiques souhaitées.

Techniques de spécification par modalité: Les systèmes multimodaux actuels bénéficient d’instructions spécifiques à chaque modalité. Par exemple:

- Pour les éléments visuels: « Concentre ton analyse sur le graphique en haut à droite de l’image »

- Pour les éléments textuels: « Utilise les informations du paragraphe 3 pour contextualiser l’image »

Approche progressive de complexité: Les benchmarks d’Anthropic (2024) démontrent qu’une décomposition des tâches multimodales complexes en sous-tâches séquentielles améliore les performances de 23% par rapport aux requêtes monolithiques. Par exemple, demander d’abord une analyse de l’image, puis une mise en relation avec le texte, puis une synthèse globale.

Contrôle des biais inter-modaux: Les modèles multimodaux peuvent parfois privilégier une modalité sur une autre. Des techniques comme le « reweighting prompt » permettent d’équilibrer l’importance accordée à chaque source d’information: « Accorde une importance égale aux informations visuelles et textuelles dans ton analyse ».

Solutions d’orchestration et d’automatisation multimodale

L’orchestration représente le niveau supérieur d’intégration, permettant de construire des pipelines complexes combinant plusieurs outils multimodaux:

Langchain Multimodal a émergé comme solution privilégiée pour l’orchestration de workflows combinant différents modèles spécialisés. Sa force réside dans les « multimodal chains » qui permettent de router automatiquement les différentes composantes d’une requête vers les modèles les plus adaptés à chaque modalité, puis de synthétiser les résultats.

LlamaIndex MultiModal excelle dans l’indexation et la recherche à travers des bases de données multimodales. Son architecture permet de créer des index hybrides où textes, images et données structurées sont accessibles via une interface unifiée, avec des capacités de recherche sémantique cross-modale particulièrement performantes.

AutoGPT Multimodal représente la frontière de l’automatisation avec sa capacité à décomposer automatiquement des objectifs complexes en sous-tâches adaptées à différents systèmes multimodaux. Son approche « objective-driven » permet de définir un résultat souhaité (comme « Crée une présentation marketing complète ») et de laisser le système orchestrer l’ensemble du processus à travers différentes modalités.

L’entreprise française Dassault Systèmes a documenté l’implémentation d’une architecture d’orchestration multimodale pour la conception assistée, permettant le passage fluide entre spécifications textuelles, modélisation 3D et simulation, réduisant de 40% le temps de conception pour certains composants aéronautiques.

Cas d’usage concrets et retours d’expérience en France

L’adoption des outils multimodaux en France présente des caractéristiques spécifiques, influencées par le tissu industriel local et le cadre réglementaire européen. Plusieurs implémentations réussies illustrent le potentiel transformateur de ces technologies.

Études de cas marketing et communication

Dans le secteur du marketing, les applications multimodales ont transformé la production de contenu et l’analyse de l’impact des campagnes:

L’Oréal France a implémenté une solution basée sur Claude 3 Opus pour analyser simultanément les conversations textuelles sur les réseaux sociaux et les images partagées par les consommateurs. Cette approche multimodale a permis d’identifier des tendances émergentes d’utilisation des produits qui n’étaient pas explicitement mentionnées dans les textes. Selon leur rapport d’innovation digitale 2024, cette méthodologie a contribué au développement de deux nouvelles gammes de produits directement inspirées des usages non-conventionnels détectés.

Publicis Sapient a développé un système d’optimisation publicitaire multimodal qui analyse simultanément le message textuel, les éléments visuels et la réponse émotionnelle mesurée des audiences (via des panels tests) pour affiner les campagnes. Cette approche intégrée a permis d’améliorer les taux d’engagement de 28% en moyenne sur les campagnes digitales, selon leur étude de cas présentée au salon Viva Technology 2024.

Radio France utilise désormais une solution multimodale pour transformer automatiquement ses contenus audio en formats visuels adaptés aux réseaux sociaux. Le système analyse le contenu sémantique des émissions, identifie les moments clés et génère des visualisations pertinentes avec sous-titrage optimisé. Cette automatisation a permis d’augmenter la production de contenu dérivé de 300% tout en réduisant les coûts de 60%.

Applications e-commerce et retail

Le secteur du commerce a rapidement adopté les solutions multimodales pour enrichir l’expérience client et optimiser les opérations:

Carrefour France a déployé une solution de recherche multimodale sur son application mobile, permettant aux clients de combiner texte et image pour trouver des produits. Par exemple, un client peut photographier un plat et demander « quels ingrédients me manquent pour préparer ceci? ». Le système identifie le plat, extrait la recette et compare avec l’historique d’achat pour suggérer les produits nécessaires. Cette fonctionnalité a augmenté le taux de conversion de 23% pour les utilisateurs l’ayant adoptée.

Le Bon Coin a implémenté un système d’évaluation automatique multimodal qui analyse simultanément les descriptions textuelles et les photos des articles pour suggérer des prix optimaux et détecter les incohérences. Cette solution réduit significativement les fraudes et améliore l’expérience utilisateur en assurant une meilleure correspondance entre descriptions et visuels. Selon leurs données internes, le système a permis de réduire les litiges liés aux descriptions trompeuses de 47%.

Sephora France utilise une solution de recommandation multimodale qui combine l’analyse des préférences textuelles exprimées par les clients, leur historique d’achat et des images de leur type de peau pour proposer des produits personnalisés. Cette approche holistique a permis d’augmenter le taux de satisfaction client de 34% et les ventes croisées de 28%.

Utilisations innovantes dans l’éducation et la formation

Le secteur éducatif français a développé des applications particulièrement innovantes des technologies multimodales:

Le CNED (Centre National d’Enseignement à Distance) a développé une plateforme d’apprentissage adaptatif multimodal qui analyse la progression des étudiants à travers leurs interactions textuelles (réponses aux questions), visuelles (temps passé sur différentes sections) et même leurs expressions faciales pendant les sessions en ligne (avec consentement explicite). Le système adapte automatiquement le format et le niveau des contenus présentés. Les premiers résultats montrent une amélioration de 24% des taux de complétion des cours pour les étudiants utilisant cette plateforme.

CentraleSupélec utilise un système de laboratoires virtuels multimodaux où les étudiants peuvent décrire textuellement une expérience, voir sa simulation visuelle en temps réel, et recevoir des explications contextuelles basées sur leurs interactions. Cette approche a permis d’augmenter l’accessibilité des travaux pratiques complexes tout en réduisant les coûts d’équipement de 65% pour certains cursus.

L’AFPA (Association pour la Formation Professionnelle des Adultes) a implémenté un assistant de formation multimodal pour les métiers techniques qui permet aux apprenants de photographier leur travail en cours (soudure, installation électrique, etc.), de poser des questions textuelles, et de recevoir des feedbacks visuels et textuels personnalisés. Cette solution a réduit le temps nécessaire à la certification de 20% tout en améliorant les taux de réussite.

Défis techniques et limitations actuelles

Malgré les avancées impressionnantes, les systèmes multimodaux font face à des défis significatifs qui limitent encore leur adoption généralisée et leur efficacité dans certains contextes.

Cohérence entre modalités : problèmes et solutions

Le défi fondamental des systèmes multimodaux reste la maintenance d’une cohérence sémantique parfaite entre les différentes modalités:

Le problème d’alignement sémantique se manifeste particulièrement lors de la génération de contenu où texte et image doivent correspondre parfaitement. Par exemple, lorsqu’un système comme DALL-E 3 génère une image à partir d’une description textuelle complexe, certains détails peuvent être omis ou mal interprétés. Selon l’étude d’OpenAI Research (2023), les éléments spatiaux (« à gauche de », « derrière ») et les attributs multiples (« une voiture rouge décapotable avec des roues noires ») présentent les taux d’erreur les plus élevés.

Les incohérences temporelles affectent particulièrement les systèmes intégrant la vidéo, où maintenir une continuité visuelle cohérente avec la narration textuelle reste problématique sur des séquences dépassant 20-30 secondes. Runway ML a documenté ce défi dans son rapport technique (décembre 2023), notant que la stabilité des attributs des objets (couleur, forme, identité) décroît de manière non-linéaire avec la durée des séquences.

Les approches correctives actuelles incluent:

- Les systèmes de vérification croisée qui comparent explicitement les représentations de différentes modalités

- Les techniques de génération itérative avec feedback multimodal

- L’intégration de contraintes explicites de cohérence dans les processus génératifs

Claude 3 Opus utilise par exemple un système de « raisonnement multimodal réflexif » qui vérifie explicitement si sa compréhension visuelle correspond à sa génération textuelle, réduisant les incohérences de 62% par rapport aux approches standards.

Performance et besoins en ressources

Les exigences computationnelles représentent un frein majeur à l’adoption généralisée:

L’inférence en temps réel des modèles multimodaux actuels nécessite des ressources GPU significatives. GPT-4V requiert environ 4 fois plus de puissance de calcul que GPT-4 en mode texte uniquement pour des requêtes comparables. Cette réalité limite l’intégration dans des applications mobiles ou edge computing.

La latence de traitement reste problématique pour les applications interactives. Selon les benchmarks de Hugging Face (2024), le temps moyen de traitement d’une requête combinant texte et image varie de 2,3 à 8,7 secondes selon la complexité, ce qui reste trop élevé pour certains cas d’usage.

Les coûts d’opération peuvent être prohibitifs pour les petites organisations. Le traitement multimodal sur les principales API commerciales reste 3 à 5 fois plus coûteux que le traitement unimodal équivalent, rendant difficile l’intégration à grande échelle pour les PME.

Des solutions émergent cependant:

- Les techniques de distillation de modèles qui créent des versions plus légères adaptées à des cas d’usage spécifiques

- L’inférence hybride cloud/edge qui répartit le traitement selon la complexité

- Les approches de quantification spécifiques aux modèles multimodaux qui réduisent significativement l’empreinte mémoire

Limitations sémantiques et conceptuelles

Au-delà des défis techniques, des limitations plus fondamentales persistent:

La compréhension contextuelle profonde reste limitée, particulièrement pour les concepts abstraits ou culturellement spécifiques. Les modèles multimodaux actuels excellent dans la reconnaissance et l’association de concepts concrets, mais peinent à saisir les nuances culturelles, l’ironie visuelle ou les références implicites.

Le raisonnement causal entre modalités représente une frontière actuelle. Les systèmes peuvent identifier des corrélations entre éléments visuels et textuels, mais établir des relations de cause à effet reste problématique. Par exemple, distinguer si un changement dans une séquence d’images est la cause ou la conséquence d’un événement décrit textuellement.

Les biais de modalité dominante se manifestent lorsque les systèmes accordent une importance disproportionnée à une modalité particulière dans leurs analyses. Dans les évaluations de MLA Benchmarks (2023), les systèmes actuels montrent une tendance à privilégier les informations textuelles en cas de contradiction subtile avec le contenu visuel, créant des « angles morts » potentiellement problématiques.

Ces limitations reflètent les défis fondamentaux de l’IA multimodale: créer une véritable compréhension unifiée plutôt qu’une simple juxtaposition d’analyses séparées.

Aspects juridiques et éthiques des systèmes multimodaux

L’émergence des systèmes multimodaux soulève des questions juridiques et éthiques spécifiques, particulièrement dans le contexte européen où le cadre réglementaire concernant l’IA évolue rapidement. Ces considérations deviennent critiques pour toute organisation envisageant le déploiement de telles technologies.

Conformité RGPD et gestion des données multimodales

Les outils multimodaux posent des défis particuliers en matière de protection des données personnelles:

Le traitement croisé des données soulève des questions juridiques nouvelles. Lorsqu’un système analyse simultanément l’image d’une personne et des données textuelles la concernant, la combinaison peut révéler des informations plus sensibles que chaque élément pris séparément. La CNIL a publié en février 2024 des recommandations spécifiques concernant les « risques d’enrichissement par corrélation multimodale », suggérant des mesures de protection renforcées.

Le consentement spécifique devient plus complexe dans un contexte multimodal. Selon l’analyse juridique publiée par le cabinet Gide Loyrette Nouel (2023), le consentement standard pour le traitement d’images peut s’avérer insuffisant lorsque ces images sont analysées en conjonction avec d’autres données. Ils recommandent l’adoption d’un « consentement multimodal explicite » détaillant précisément les types d’analyses croisées effectuées.

La minimisation des données représente un défi technique dans les systèmes multimodaux. Comment appliquer ce principe fondamental du RGPD lorsque la valeur du système réside précisément dans sa capacité à croiser différentes sources d’information? Des solutions techniques émergent, comme l’anonymisation sélective par modalité développée par l’INRIA, qui permet de traiter des données biométriques visuelles sans les conserver tout en maintenant les capacités d’analyse multimodale.

L’entrée en application complète de l’AI Act européen en 2025 a également précisé les obligations spécifiques aux systèmes multimodaux, les classant majoritairement dans la catégorie « haut risque » lorsqu’ils sont utilisés pour des décisions automatisées affectant des personnes.

Droits d’auteur et propriété intellectuelle des contenus générés

La génération multimodale soulève des questions inédites en matière de propriété intellectuelle:

L’utilisation d’œuvres protégées pour l’entraînement fait l’objet de débats juridiques intenses. L’affaire « Stability AI vs Getty Images » (jugée en mars 2024) a établi un précédent important en confirmant que l’utilisation non autorisée d’images protégées pour l’entraînement de modèles génératifs constitue une violation du droit d’auteur dans l’UE, même si les images individuelles ne sont pas reproduites à l’identique.

La paternité des créations multimodales reste juridiquement ambiguë. Lorsqu’un utilisateur fournit une description textuelle et une image de référence, et qu’un système comme Runway Gen-3 génère une vidéo, qui détient les droits? La jurisprudence européenne tend vers une reconnaissance de droits partagés, avec une distinction entre « l’intention créative » (protégeable) et « l’exécution technique » (non protégeable).

Les mécanismes de traçabilité des sources deviennent essentiels dans ce contexte. Des initiatives comme le Content Credentials (développé par la Coalition for Content Provenance and Authenticity) permettent de maintenir l’historique des transformations multimodales, facilitant l’attribution des contributions créatives. Plusieurs entreprises françaises, dont Dassault Systèmes, ont adopté ce standard pour leurs outils de génération multimodale.

L’incertitude juridique actuelle a conduit certaines organisations françaises à développer des politiques internes strictes concernant l’utilisation des contenus générés, comme la règle « 50% d’édition humaine » adoptée par plusieurs agences créatives qui exige une intervention substantielle sur tout contenu généré avant son utilisation commerciale.

Transparence algorithmique et explicabilité des décisions

La nature « boîte noire » des systèmes multimodaux pose des défis particuliers en matière de transparence:

L’explicabilité des décisions multimodales s’avère plus complexe que pour les systèmes unimodaux. Comment expliquer qu’une combinaison spécifique d’éléments visuels et textuels a conduit à une décision particulière? Le CNRS a publié en 2024 un rapport détaillant les défis spécifiques de l’explicabilité multimodale, soulignant que « l’interaction entre modalités crée des effets émergents difficiles à décomposer en facteurs explicatifs simples ».

Les biais amplifiés par l’interaction entre modalités représentent un risque éthique majeur. Une étude de Mistral AI (2023) a démontré que certains biais peuvent rester indétectables dans chaque modalité isolée, mais émerger lors de l’analyse croisée. Par exemple, des stéréotypes professionnels peuvent être renforcés lorsque texte et image sont analysés conjointement, même si chaque analyse séparée semble équitable.

Les approches d’audit spécifiques se développent pour répondre à ces défis. Des méthodologies comme le « Multimodal Algorithmic Impact Assessment » proposé par la DINUM France incluent des tests spécifiques pour évaluer les biais intersectionnels et les effets émergents des systèmes multimodaux. Cette approche a été adoptée par plusieurs institutions publiques françaises avant tout déploiement à grande échelle.

Les entreprises françaises commencent également à intégrer ces considérations dès la conception de leurs solutions multimodales, suivant une approche « ethics-by-design » qui inclut des mécanismes de vérification automatique des biais potentiels et des interfaces explicatives pour les utilisateurs finaux.

Futur de l’IA multimodale : tendances et évolutions à suivre

L’IA multimodale évolue rapidement, avec plusieurs tendances majeures qui façonneront son développement dans les prochaines années. Ces évolutions ouvrent de nouvelles perspectives tout en soulevant des questions fondamentales sur l’avenir de nos interactions avec la technologie.

Convergence vers des modèles universels multimodaux

Nous observons une progression claire vers des architectures toujours plus unifiées:

Les modèles foundation multimodaux représentent l’horizon actuel de la recherche. Contrairement aux premiers systèmes qui utilisaient des encodeurs spécialisés par modalité, la nouvelle génération vise une architecture véritablement unifiée capable de traiter n’importe quelle modalité avec les mêmes mécanismes fondamentaux. Le projet Flamingo de DeepMind (présenté en mai 2023) illustre cette approche avec une architecture capable d’intégrer progressivement de nouvelles modalités sans reconstruction complète.

L’émergence de modèles multi-tâches capables de comprendre les intentions à travers différentes modalités constitue une avancée significative. Par exemple, le système Gemini 1.5 Pro peut désormais comprendre si un utilisateur souhaite obtenir une description, une analyse ou une transformation créative d’une entrée multimodale, sans instruction explicite, grâce à ce que Google appelle « l’inférence d’intention multimodale ».

Les capacités d’apprentissage continu multimodal permettront bientôt aux systèmes de s’améliorer à travers différentes modalités sans oublier les capacités précédemment acquises. Les travaux de Yann LeCun sur l’architecture JEPA (Joint Embedding Predictive Architecture) présentés en 2023 posent les bases théoriques de cette évolution, avec des premiers prototypes atteignant des performances prometteuses sur des tâches de transfert multimodal.

Ces évolutions convergent vers ce que les chercheurs d’Anthropic décrivent comme un « système cognitif unifié artificiel » capable de percevoir et raisonner à travers différentes modalités de manière intégrée, similaire à la cognition humaine mais avec des capacités potentiellement plus étendues.

Démocratisation des outils : perspectives pour les PME

L’accessibilité des technologies multimodales connaît une évolution positive:

La réduction significative des coûts computationnels ouvre de nouvelles possibilités. Les techniques d’optimisation comme la quantification à 4-bits et les architectures mixtes ont permis de réduire l’empreinte computationnelle des modèles multimodaux de 70% en moyenne depuis 2023, selon une étude de Hugging Face (mars 2024). Cette tendance devrait se poursuivre, rendant ces technologies accessibles à des organisations disposant de ressources limitées.

Les solutions SaaS multimodales spécialisées se multiplient, permettant aux PME d’adopter ces technologies sans investissements massifs en infrastructure ou expertise technique. Des plateformes comme MultiModal.io (startup française) proposent désormais des interfaces simplifiées pour des cas d’usage spécifiques (analyse de produits e-commerce, création de contenu marketing) avec un modèle tarifaire adapté aux structures moyennes.

Les approches « no-code/low-code » pour l’IA multimodale commencent à émerger. Des solutions comme la plateforme française Huggingface Blocks permettent désormais de construire des workflows multimodaux personnalisés sans compétences en programmation, en assemblant visuellement des modules pré-construits pour différentes tâches (analyse d’image, génération de texte, classification).

Les statistiques de la FEVAD (2024) montrent que l’adoption des outils multimodaux par les PME françaises a doublé en un an, passant de 12% à 24%, principalement dans les secteurs du e-commerce, du tourisme et des services professionnels, suggérant une démocratisation progressive mais réelle.

Nouvelles modalités et interfaces émergentes

L’horizon de l’IA multimodale s’étend au-delà des modalités traditionnelles:

L’intégration des données haptiques représente une frontière prometteuse. Des recherches menées à l’Université de Grenoble Alpes (2023) explorent l’intégration du retour tactile dans les systèmes multimodaux, permettant par exemple à un système de comprendre et générer des sensations de texture en coordination avec des représentations visuelles et textuelles. Ces avancées ouvrent des perspectives fascinantes pour les applications en réalité virtuelle et augmentée.

Les interfaces cerveau-machine commencent à être intégrées comme nouvelle modalité d’entrée. Le projet Neuralink et ses équivalents académiques explorent la possibilité d’utiliser les signaux neuronaux comme une modalité supplémentaire dans les systèmes multimodaux. Bien que ces recherches en soient à leurs débuts, des résultats préliminaires montrent qu’il est possible d’établir des corrélations entre activité cérébrale et représentations visuelles ou linguistiques.

Les systèmes sensoriels artificiels étendus dépassent les capacités humaines traditionnelles. Des plateformes expérimentales intègrent désormais des données habituellement inaccessibles aux sens humains (infrarouge, ultrasons, données chimiques) dans des représentations multimodales cohérentes. Ces systèmes ouvrent des possibilités révolutionnaires pour des domaines comme la surveillance environnementale ou la médecine diagnostique.

La convergence de ces nouvelles modalités avec les interfaces existantes laisse entrevoir ce que les chercheurs du MIT Media Lab appellent des « systèmes cognitifs étendus », où l’IA multimodale servirait d’interface fluide entre les humains et des domaines sensoriels auparavant inaccessibles, transformant fondamentalement notre rapport au monde.

FAQ : Questions fréquentes sur les outils d’IA multimodale

Un modèle d’IA unimodal est conçu pour traiter un seul type de données (uniquement du texte, uniquement des images, etc.) et possède une architecture optimisée pour cette modalité spécifique. En revanche, un modèle multimodal peut traiter, comprendre et générer plusieurs types de données simultanément (texte, images, audio, vidéo) tout en établissant des relations sémantiques entre ces différentes modalités.

La différence fondamentale réside dans la capacité des modèles multimodaux à créer des représentations unifiées qui capturent les relations entre différents types d’information, permettant par exemple de comprendre comment une description textuelle correspond à des éléments visuels spécifiques, ou de générer une image cohérente avec un prompt textuel et un exemple visuel.

L’implémentation d’outils multimodaux nécessite généralement:

– Infrastructure technique: Pour les solutions cloud, une connexion internet stable et sécurisée; pour les déploiements on-premise, des ressources GPU significatives (minimum NVIDIA A100 ou équivalent pour les modèles récents)

– Expertise: Compétences en intégration API pour les solutions SaaS, ou data scientists spécialisés pour les déploiements personnalisés

– Données: Collections de données structurées si des adaptations spécifiques au domaine sont nécessaires

– Sécurité: Protocoles de gestion des données conformes au RGPD, particulièrement importants pour les systèmes traitant plusieurs types de données personnelles

– Budget: Prévoir non seulement les coûts d’API/infrastructure mais aussi les ressources pour l’intégration, la formation et la maintenance

Selon une étude de Deloitte (2024), les organisations réussissant leur implémentation consacrent en moyenne 30% du budget total à la formation et à l’adaptation des processus de travail, contre seulement 40% pour la technologie elle-même.

L’évaluation du ROI doit considérer plusieurs facteurs spécifiques aux solutions multimodales:

– Gains d’efficacité opérationnelle: Mesurer la réduction du temps nécessaire pour accomplir des tâches impliquant plusieurs modalités (par exemple, analyse d’images et génération de descriptions)

– Coûts évités d’intégration: Quantifier les ressources économisées en évitant le développement d’intégrations entre plusieurs outils spécialisés

– Amélioration qualitative: Évaluer la cohérence sémantique entre les modalités, impossible à atteindre avec des outils séparés

– Nouvelles capacités: Identifier les processus entièrement nouveaux rendus possibles par l’approche multimodale

Une méthodologie développée par le cabinet français Converteo (2023) propose un « indice de synergie multimodale » qui compare la performance d’une solution intégrée à celle d’outils séparés sur des tâches identiques. Leurs analyses suggèrent qu’au-delà de trois modalités différentes, les solutions intégrées offrent systématiquement un meilleur ROI, principalement grâce aux économies d’intégration et à la cohérence améliorée.

Exploiter efficacement les outils multimodaux requiert une combinaison de compétences techniques et créatives:

– Prompt engineering multimodal: Capacité à formuler des instructions claires qui guident efficacement le système à travers différentes modalités

– Pensée systémique: Aptitude à concevoir des workflows qui exploitent les synergies entre différentes modalités

– Littératie visuelle: Compréhension des principes de design et de communication visuelle pour évaluer et améliorer les sorties multimodales

– Compétences éditoriales: Capacité à affiner et harmoniser les contenus générés à travers différentes modalités

– Compréhension des limites: Connaissance des capacités et contraintes spécifiques aux systèmes multimodaux

Plusieurs organismes comme l’École 42 et CentraleSupélec ont développé des modules de formation spécifiques à l’IA multimodale, reconnaissant qu’il s’agit d’un ensemble de compétences distinct de l’IA traditionnelle.

L’écosystème actuel offre des solutions adaptées aux différentes tailles d’organisations:

Les PME peuvent désormais accéder à des technologies multimodales via:

– Solutions SaaS spécialisées avec tarification flexible (à partir de 200-500€/mois)

– API multimodales avec facturation à l’usage (Claude API, OpenAI API, etc.)

– Modèles open-source optimisés pour fonctionner sur des infrastructures modestes

– Solutions sectorielles prépackagées nécessitant peu d’expertise technique

L’initiative France IA 2025 a également mis en place un programme de chèques innovation spécifiquement pour l’adoption de l’IA par les PME, avec une enveloppe dédiée aux technologies multimodales.

Selon une étude BPI France (mars 2024), 32% des PME françaises prévoient d’implémenter au moins une solution d’IA multimodale dans les 12 prochains mois, contre seulement 8% en 2023, témoignant d’une accessibilité croissante.

Conclusion

L’IA multimodale représente bien plus qu’une simple évolution technologique – elle constitue un changement de paradigme fondamental dans notre relation avec l’intelligence artificielle. En fusionnant les frontières entre texte, image, audio et vidéo, ces systèmes créent des expériences plus naturelles, contextuelles et puissantes qui correspondent davantage à notre propre perception multisensorielle du monde.

Les outils multimodaux de 2025 ont atteint un niveau de maturité qui les rend désormais accessibles et exploitables par une large gamme d’organisations, des grands groupes aux PME innovantes. La démocratisation progressive de ces technologies, combinée à l’émergence de solutions spécialisées par secteur, ouvre des perspectives d’innovation dans pratiquement tous les domaines d’activité.

Cependant, cette révolution s’accompagne de responsabilités nouvelles. Les questions juridiques, éthiques et organisationnelles soulevées par ces technologies doivent être adressées avec la même rigueur que les défis techniques. La conformité réglementaire, particulièrement dans le contexte européen, devient un élément central de toute stratégie d’adoption.

Pour les organisations françaises, l’opportunité est double: devenir utilisatrices avisées de ces technologies pour transformer leurs opérations, mais aussi contribuer activement à l’émergence d’un écosystème d’IA multimodale européen, gouverné par nos valeurs et adapté à nos spécificités culturelles et économiques.

L’avenir appartient aux organisations qui sauront non seulement adopter ces outils, mais les intégrer de manière réfléchie dans une vision stratégique plus large, centrée sur l’humain et la création de valeur durable.

A retenir

– Les outils d’IA multimodaux transforment les workflows en permettant l’intégration fluide entre texte, image, audio et vidéo

– L’accessibilité de ces technologies s’améliore rapidement, rendant leur adoption possible pour des organisations de toute taille

– La maîtrise des techniques de prompting multimodal et d’orchestration devient une compétence stratégique

– Les considérations éthiques et juridiques spécifiques doivent être intégrées dès la conception des projets multimodaux

– L’évolution vers des modèles toujours plus unifiés et de nouvelles modalités sensorielles ouvre des perspectives inédites

Sources et références

- OpenAI Research, « Multimodal Understanding in Foundation Models », décembre 2023

- Anthropic, « Benchmarking Multimodal Performance Across Domains », février 2024

- INRIA, « Advances in French Natural Language and Visual Processing », octobre 2023

- Mistral AI, « L’avenir multimodal de l’intelligence artificielle », janvier 2024

- DINUM France, « État des lieux des implémentations d’IA multimodale dans le secteur public français », mars 2024

- CNRS, « Ethical Considerations in Multimodal AI Systems », février 2024

- Deloitte Digital, « The ROI of Multimodal AI Implementation », janvier 2024

- Hugging Face, « Model Optimization Techniques for Multimodal Systems », mars 2024

- Nature Medicine, « Multimodal Medical Diagnostics: Comparative Performance Study », janvier 2024

- BPI France, « Adoption de l’IA par les PME françaises: Tendances 2024 », mars 2024

- FEVAD, « Impact des technologies multimodales sur l’e-commerce français », avril 2024

- Converteo, « Méthodologies d’évaluation des systèmes IA multimodaux », novembre 2023

- Adobe, « Creative Workflows Transformation with Multimodal AI », décembre 2023

- Gide Loyrette Nouel, « Implications juridiques des systèmes d’IA multimodaux dans le contexte RGPD », octobre 2023